Was ist Databricks Training?

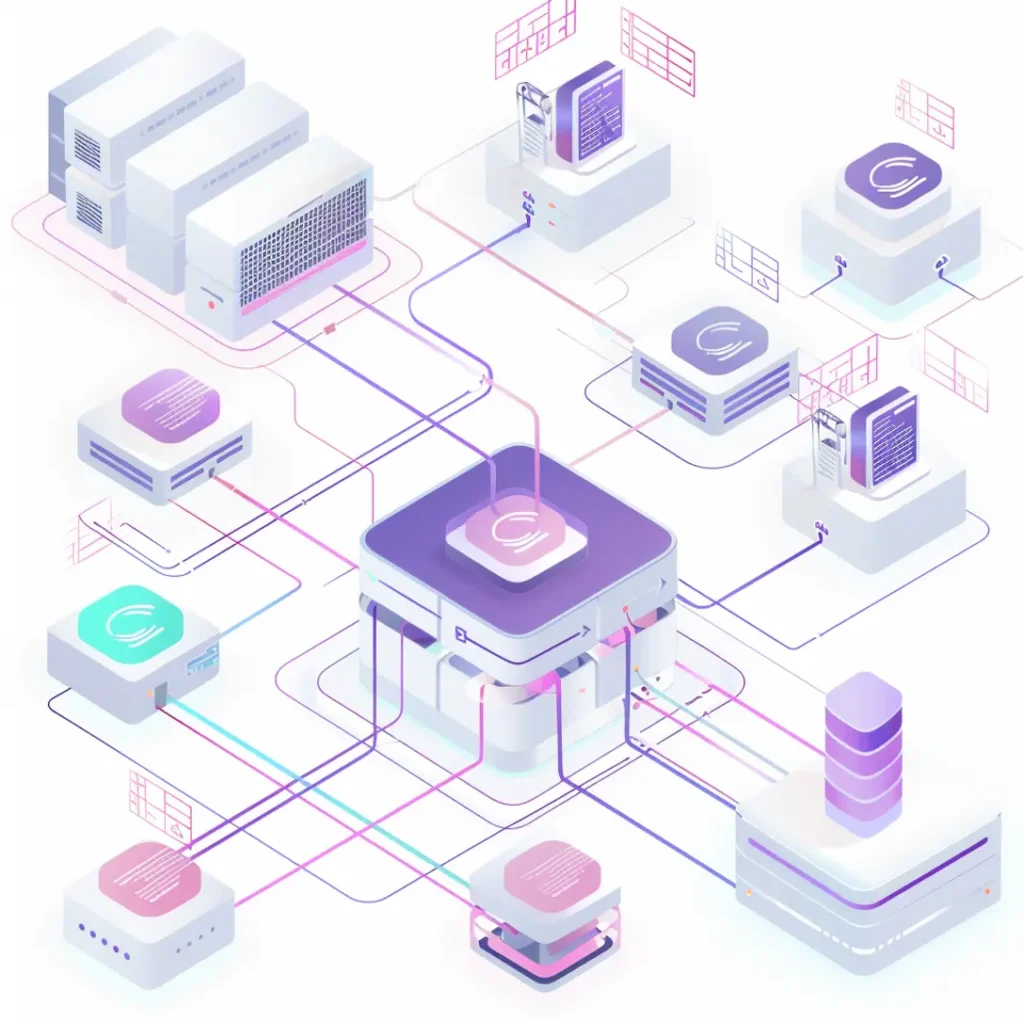

Der dreitägige Databricks-Workshop von Thinkport bietet eine umfassende Einführung in die mächtige Datenplattform, die sowohl für Data Engineering als auch für Machine Learning und Data Science optimiert ist.

In den ersten beiden Tagen werden die Teilnehmer durch die Grundlagen von Databricks geführt, darunter Delta Lake, Data Streaming, Data Warehousing und Data Governance. Der Workshop vertieft sich in die Databricks-Architektur, Unity Catalog für effiziente Datenorganisation und -verwaltung. Praktische Übungen umfassen das Arbeiten mit Delta Lake, die Integration von Daten aus verschiedenen Quellen und die Entwicklung von Data Engineering Pipelines.

Am dritten Tag liegt der Fokus auf Data Engineering, DevOps und fortgeschrittenen Themen wie Structured Streaming und Machine Learning. Die Teilnehmer werden in die Strukturierung von Datenverarbeitungspipelines eingeführt, setzen Continuous Integration und Deployment mit dbx um und erkunden fortgeschrittene Anwendungen von Delta Live Tables sowie Machine Learning-Beispiele. Der Workshop bietet nicht nur theoretisches Wissen, sondern auch praxisnahe Labore, um die erworbenen Fähigkeiten unmittelbar anzuwenden und zu festigen.

Module 1: Databricks Intro

Delta Lake: Grundlagen und Konzepte von Delta Lake, einschließlich Transaktionen und Versionierung.

Data Engineering: Überblick über Datenengineering in Databricks, einschließlich grundlegender Transformationen und Operationen.

Data Streaming: Einführung in die Verarbeitung von Echtzeitdaten und Streaming mit Databricks.

Data Warehousing: Konzepte und Anwendungen von Data Warehousing in Databricks.

Data Sharing: Methoden und Werkzeuge zum Teilen von Daten in Databricks.

Machine Learning / Data Science: Grundlagen der maschinellen Lern- und Datenwissenschaftsanwendungen in Databricks.

- Data Governance: Überblick über die Datenverwaltung und -kontrolle in Databricks.

Module 2: Databricks Architektur

Control plane and data plane: Unterscheidung zwischen Steuerungsebene und Datenebene in der Databricks-Architektur.

Data plane: Cluster- und SQL-Warehouse-Konzepte, einschließlich serverloser Implementierungen.

Module 3: Unity Catalog

Intro: Einführung in den Unity Catalog und seine Rolle in der Datenorganisation.

Setup: Einrichtung des Unity Catalog in einer Cloud-Umgebung mit einem Data Lake.

Hierarchy: Struktur von Metastore, Katalog, Schema und Tabelle im Unity Catalog.

Storage Credentials und Access Connectors: Sicherheitsaspekte für den Zugriff auf Daten im Unity Catalog.

Managed Tables und Unmanaged Tables: Unterschiede und Anwendungen.

(Materialized) Views: Verwendung von Ansichten im Unity Catalog.

Unity catalog vs. Legacy Access Model: Vergleich mit dem alten Zugriffsmodell (Hive Metastores + Table Access Control).

Hands-on Lab: Praktische Einrichtung von Unity Catalog-Objekten (Externer Speicherort, Katalog, Schema).

Module 4: Data Integration

Intro: Einführung in die Datenintegration in Databricks.

Hands-on Lab: Praktische Übungen zum Abrufen von CSV-Daten über eine API.

Optional: On-prem Integration, Databricks Partner Connect: Erweiterungsmöglichkeiten für Datenintegration.

Module 5: Data Engineering

Delta Lake Features: Fortgeschrittene Funktionen von Delta Lake.

History and „Time Travel“: Historische Datenansichten und Zeitreisen in Delta Lake.

Vacuuming: Bereinigung und Verwaltung von Daten in Delta Lake.

Hands-on Lab: Datenverarbeitung mit PySpark auf einem Spark-Cluster.

Hands-on Lab: Datenverarbeitung mit SQL auf einem SQL-Warehouse.

Intro Databricks Jobs (Workflows): Überblick über Workflows in Databricks.

Hands-on Lab: Workflow zur Orchestrierung von Datenverarbeitungspipelines.

Good Practices: Best Practices für Cluster- und SQL-Warehouse-Konfiguration, Tabellepartitionierung und ODBC-Zugriff auf Databricks.

Module 6: DevOps

Repositories in Databricks: Nutzung von Repositories für die Codeverwaltung in Databricks.

Introduce CI/CD with dbx: Einführung in Continuous Integration und Continuous Deployment mit dbx.

Optional: Hands-on Lab: Praktische Einrichtung von Workflow CI/CD mit dbx.

Module 7: Structured Streaming and ML

Intro: Einführung in die strukturierte Datenverarbeitung und maschinelles Lernen.

Hands-on Lab: Datenverarbeitung mit der Structured Streaming API.

Delta Live Tables Introduction: Konzepte und Anwendungen von Delta Live Tables.

Hands-on Lab: Beispiel für Delta Live Tables.

ML and ML-Ops Introduction: Überblick über maschinelles Lernen und ML Operations.

Hands-on Lab: Beispiel für maschinelles Lernen.